几天前,Meta发布了史上首个图像分割基础模型——SAM(Segment Anything Model),将NLP领域的prompt范式引进CV,让模型可以通过prompt一键抠图。

SAM一经发布,瞬间“炸场”。网友直呼:CV不存在了!

英伟达AI科学家Jim Fan对此赞叹道:我们已经来到了计算机视觉领域的「GPT-3时刻」!

Meta在博客中兴奋地表示:“可以预计,在未来,在任何需要在图像中查找和分割对象的应用中,都有SAM的用武之地。

SAM之所以如此强大得益于它在包含超过10亿个掩码的多样化、高质量数据集(SA-1B)上进行训练,这使它能够泛化到新类型的对象和图像,超出它在训练期间观察到的内容;以及引入NLP领域的prompt范式,用户通过合理的prompt即可完成图像分割任务,无需额外训练实现“开箱即用”。可以说,Meta实现了一个完全不同的CV范式,你可以在一个统一框架prompt encoder内,指定一个点、一个边界框、一句话,直接一键分割出物体。

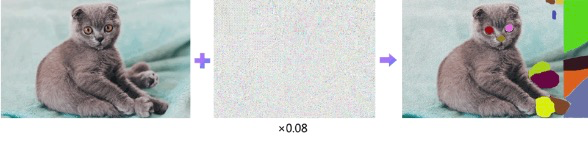

不过,瑞莱智慧RealAI要来“泼泼冷水”了。RealAI算法团队刚刚研究发现,只要在图片上添加一些对抗样本,SAM模型“分割一切”的本事,就会瞬间失灵。

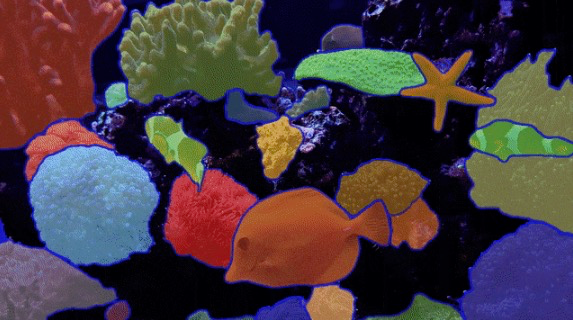

原本SAM可以很好地自动分割图像中的所有内容:

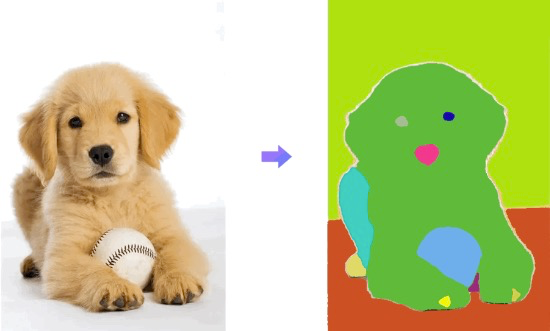

给图像添加干扰非常微小的对抗噪声后,SAM就只会“瞎割一气”:

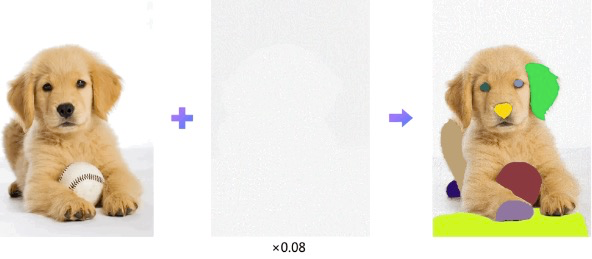

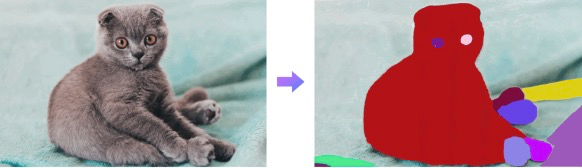

下图同理:

这充分说明:尽管SAM模型功能十分强大,但也同样存在安全风险。SAM虽然是一种新的CV范式,但算法本身仍然属于深度学习模型范畴,而深度学习模型本身就存在着易受对抗样本攻击的安全隐患。攻击者可以通过向良性数据中添加特定的扰动,生成对抗样本。附加轻微扰动的对抗样本不会影响人类的判断,却会使深度学习模型产生错误结果。我们针对SAM的模型输出,通过结合MI-FGSM【Dong et al., Boosting Adversarial Attacks with Momentum, CVPR 2018(Spotlight).】等攻击方法生成对抗样本,使得SAM模型“分割一切”的本事瞬间失灵。

这已经不是RealAI团队第一次拿对抗样本“搞事情”了。在此之前,团队还用对抗样本眼镜攻破19款主流商用手机的人脸解锁系统;将对抗样本打印在衣服上使得人体在目标检测系统中“隐身”;通过修改锥桶形状让自动驾驶感知系统无法识别……

戴上对抗样本眼镜攻破手机人脸解锁

RealAI团队所做的这一切,都只为让开启“狂飙”模式的人工智能更加安全,帮它“系上安全带”。包括SAM在内的上述AI视觉模型,之所以会被RealAI团队攻破,本质上是深度学习方法的先天缺陷,语音识别、文本处理等技术都存在被对抗样本攻击的漏洞,具有普遍性。

近几个月来,狂飙突进的大模型自然也不例外。除了对抗样本攻击,AI大模型还存在幻想、生产歧视、排斥和有害内容、数据泄露等安全问题,威胁大模型的应用生态和国家安全。事实上,无论是学术界、产业界还是监管机构,都早已意识到了风险。

4月11日,国家互联网信息办公室发布《关于<生成式人工智能服务管理办法(征求意见稿)>公开征求意见的通知》。该意见稿在第十四条就明确规定:提供者应当在生命周期内,提供安全、稳健、持续的服务,保障用户正常使用。在该意见稿发布前,已有多国监管部门表示密切关注ChatGPT引发的数据安全等问题。

未来,大模型自身的安全和可靠性问题,无疑将成为其应用发展的瓶颈性问题。如何更好地实现这一通用目的技术的发展和安全动态平衡,将成为人工智能企业的重要课题,也将酝酿新的产业机遇。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )