极客网·极客说4月19日, 华为战略研究院院长周红博士在第20届华为全球分析师大会期间做了主题为“建设智能世界的假设与愿景-从经验、知识到智能”的主题演讲。他指出,迈向智能世界需要解决的两大核心问题是未来通信和未来计算。在通信上,要大胆探索有别于香农定理的前提条件和应用场景;在计算上,要进一步明确人工智能的目标定义、提升正确性、适应性和高效性。

以下是周红博士发言精简内容:

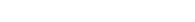

在去年的分析师大会上,我分享了迈向未来智能世界的科学假设与商业愿景,并提出了十个问题和挑战。在过去的一年中,我们与学术界、产业界科学家做了广泛交流,探讨了迈向智能世界需要解决的两大核心问题:未来通信和未来计算。

今天,我将重点分享在这两个问题上的一些思考。

首先是在通信领域。75年前,香农提出了3个定理。第一定理是可变长无失真信源编码,第二定理是有噪声情况下的信道编码,第三定理是保真度下的信源编码。在第一和第三定理中,香农假设信源是离散无记忆的,当时通信采用的是经典极化电磁场,传播环境比较简单,没有考虑高楼大厦林立的场景。

这些年学术界发现一些新的物理现象,比如自愈性的非衍射波束、轨道角动量OAM电磁场传播等,以及出现一些新技术,比如飞秒激光器,人工智能等。这些都是香农当年视野之外的,所以我认为,在未来的通信上还有很大的发展空间。通信网络是建设智能世界的基础,需要考虑敢于打破既有理论与技术瓶颈的条条框框,实现成百上千倍的提升,才能大踏步前行。

其次是计算。智能应用的迅速发展,过去十年,AI算法的算力需求提升了四十万倍。

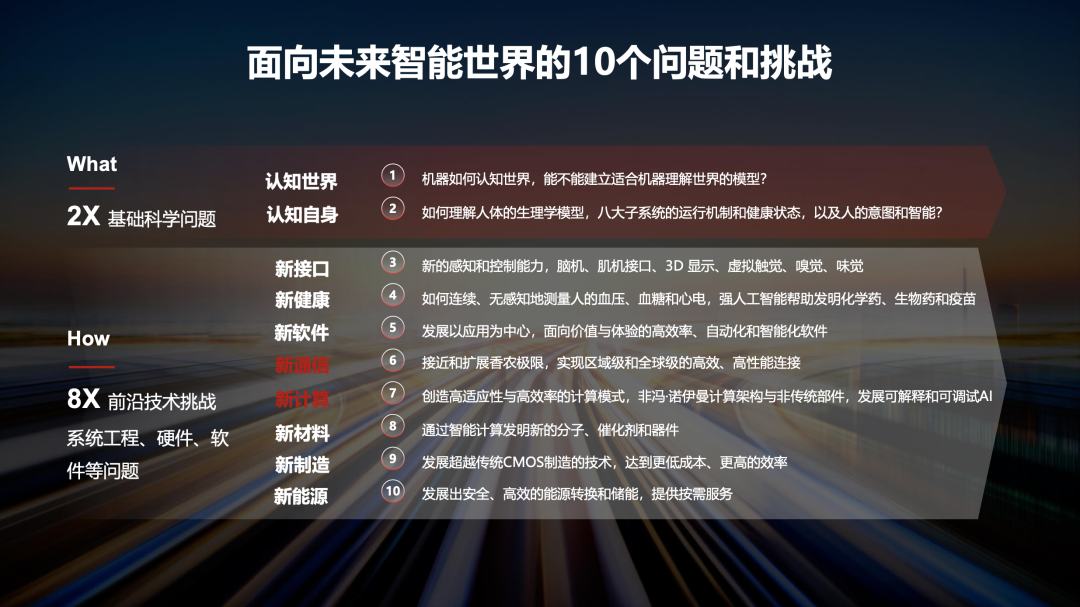

麻省理工的Max Tegmark教授在《生命3.0》书中,给出了一个AI能力地图。目前在山脚处很多能力上,AI已经超越人类,比如象棋、围棋等。在山腰上的一些能力上,人们还在不断研究提升中,例如自动驾驶、图像识别、语言文字处理等。在接近山顶的能力上,例如编程、科学研究、定理自动验证和自动证明等,学术界和产业界已经有一些探索。随着计算模式的不断优化、算力的不断提升、有了更多和更好的数据,AI将能更好地服务于人类社会的进步。

在AI能力快速提升的情况下,我认为AI目前还面临三个重要的挑战:AI的目标定义、正确性与适应性、以及效率。

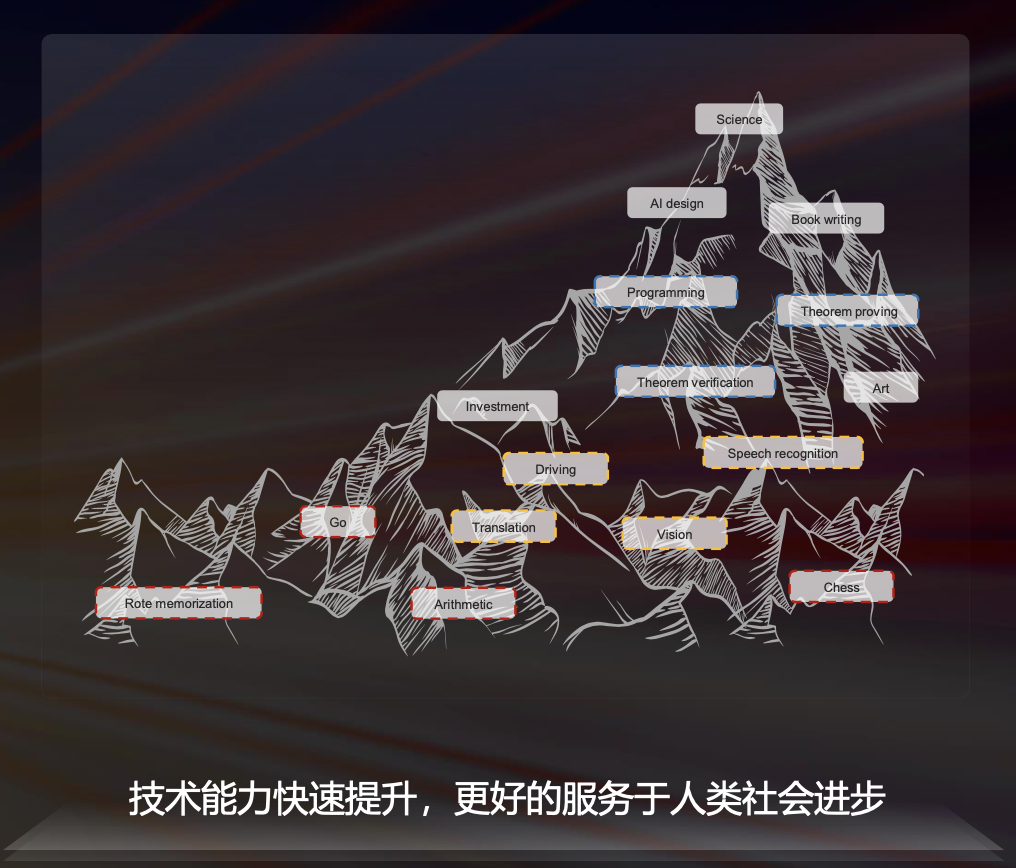

第一个挑战:缺乏共识的目标定义

对于AI,除了通过规则和法律来加强AI的伦理和治理外,缺乏目标定义也是一个关键挑战。杜克大学的物理学家Adrian Bejan教授在《生命的物理学》书中,列出了对智能的二十多种目标定义,有的强调理解和认知能力、有的强调学习和思考能力、有的强调适应和行动能力等等。

如果没有定义清楚并达成共识,就很难确保AI发展的目标与人类一致,也很难合理地分类和科学地计算。人工智能在历史上有不同的流派,例如符号学派、贝叶斯学派、进化学派、行为学派,以及联结学派等,它们还没有很好地融合起来,缺乏共识的目标定义是重要的原因之一。

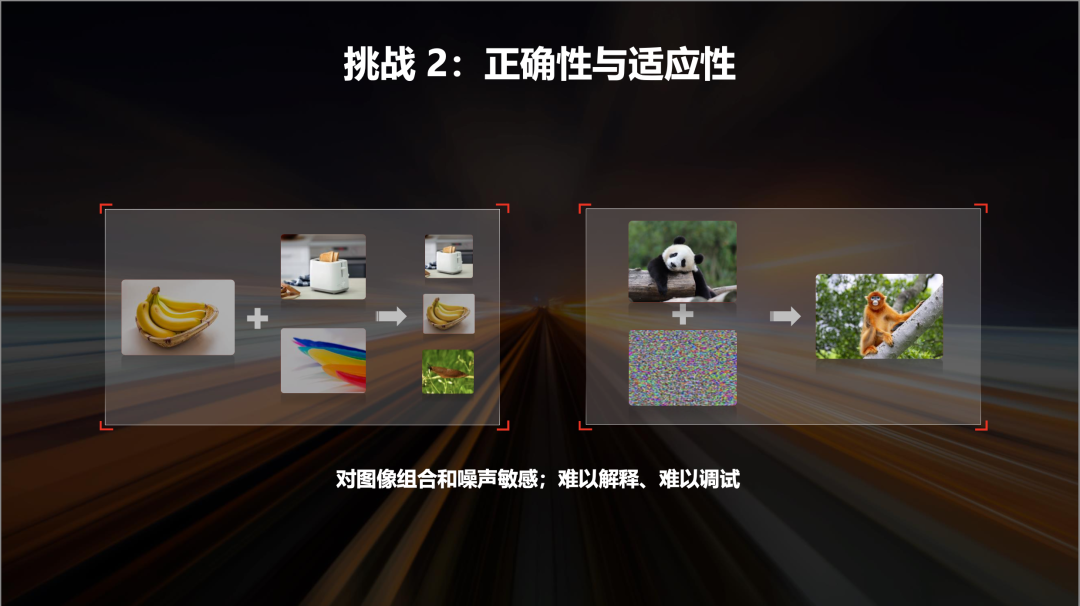

第二个挑战:正确性和适应性挑战

依靠大数据统计规律进行的学习,会依赖于采样的覆盖面和数据的正确性,如果错误使用,就可能导致结果不稳定和偏见的风险,出现“黑天鹅”事件。

比如用统计和相关计算模式来识别香蕉,如果我们在香蕉边上放一些其他图片,识别结果可能从香蕉变成烤箱,中间还有一定的比例是鼻涕虫;熊猫图片加上一些肉眼几乎不可见的小噪声,也可能被识别成长臂猿。这些图片用人眼来看是一目了然的,但是人工智能为什么会犯错,这很难解释。因为AI的能力分布在巨大的参数中,出了这些问题,我们既无法解释、也难以调试。

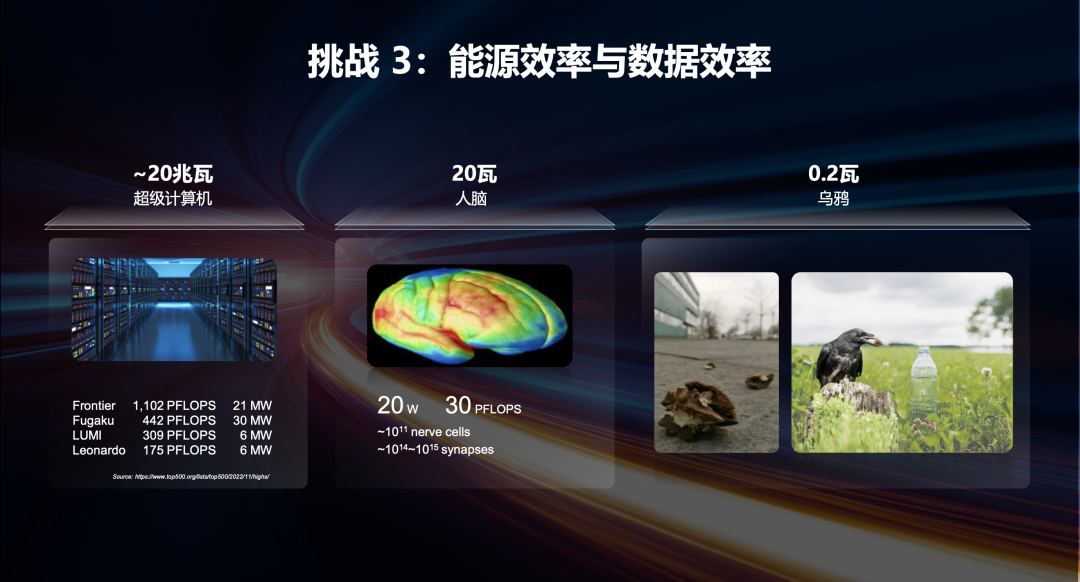

第三个挑战:AI的效率

2022年第60届全球超级计算机Top500排名第一的计算机是Frontier,计算性能约1102PFLOPS,能耗是2千1百万瓦;而相比之下,人脑只需要约20瓦就能等效处理约30PFLOPS的计算。可见当前这些超级计算机单位能量的计算效率要比人脑低大约三万倍到十万倍。

除此之外还有数据效率。我们除了通过从大数据中得到统计规律,来认识和理解世界外,能不能从小数据中进行思考,发现逻辑性,形成概念,抽象出原则和规律?

面对挑战,如何突破?

首先,建议从实用的角度,来发展知识和智能。比如通过从外部环境和我们自身的事实和现象的经验中,归纳、抽象、验证其概念、属性、关系和运行规律,来发展知识。通过感知与交互、计算或者试错,在复杂的环境和有限的资源下达成目标,来发展智能。

近几年学术界有很多跳出Transformer之外的新型AI架构的思考。我建议发展感知与建模、知识自动生成、自动化求解三个核心部分,通过从多模态感知融合与建模,到“知识+数据”驱动的决策,实现更高正确性的自主智能系统。希望上述思想和技术能够映射到未来的自主系统中,更好地支持自动驾驶网络、自动驾驶汽车、云服务等领域。

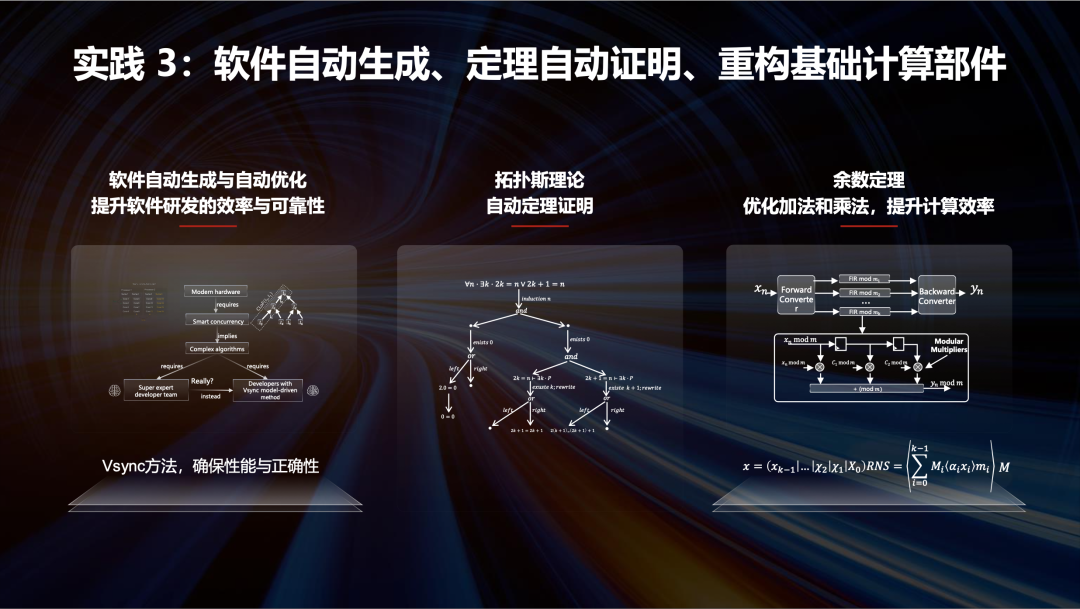

其次,是发展更好的计算模式,以及与之匹配的计算架构与计算部件,来持续提升智能计算的效率。

我曾和菲尔兹奖教授Laurent Lafforgue讨论,当前在视觉与空间计算上,往往采用像素点来表达物体,但是绝大部分物体的识别与其像素点的颜色没有直接的关系,甚至是毫无关系,它们在不同的光下呈现不同的颜色,可以通过几何流形来进行表达和计算,看看能不能用很小的数据量来抓住物体的不变性。

EPFL的Gestner和Kistlei等教授写了一本《神经动力学》的书,介绍了人大脑皮层的功能柱、以及功能柱中的六层连接情况,这样的浅度神经网络架构,会不会比深度学习更高效?

在当前的很多AI计算上,面临存储瓶颈的问题,我们往往要花比计算多上百倍的时间来读写与搬移数据,今后能不能抛开传统的冯·诺依曼架构的处理器、指令集、总线、逻辑器件和存储器件,围绕先进AI计算模式的需要来定义新的架构与部件?

以下是华为在计算领域所做的一些探索。

AI for Industry:通过行业大模型促进价值创造

华为在视觉、语言文字、图网络、多模态等专用L0基础大模型之上,形成L1行业专用大模型,来降低开发门槛、提升泛化能力,解决应用碎片化的问题,推动从“作坊式”走向工业化升级,帮助电力、煤矿、交通、制造等重要行业,提升作业效率、提升安全性。比如,在煤矿场景,华为帮助客户通过模型训练与推理,来实现瓦斯浓度的超前预警、作业序列的风险防范、以及作业质量的智能验收;华为的智慧港口方案,已经在天津、青岛、上海、深圳等港口实现智慧化应用。华为机场与轨道军团在呼和浩特、武汉、西安、深圳、香港等地与客户及合作伙伴们一起探索城轨、铁路与机场的数字化转型,不仅提升作业安全性与效率,还提升用户体验与满意度。比如在深圳机场,通过基于云和大数据以及AI创新,实现了智能机位分配,每年可以节省260万旅客免坐摆渡车,成为全球数字化转型的标杆。

AI for Science:极大帮助提升科学研究的能力

比如,我们通过构造新型的、地理信息3D Transformer编码结构,以及层次化时域聚合方法,推出盘古气象大模型,通过更精准、高效的学习与推理机制,从大自然历史运转出来的数据中提取出全球气象先验知识,代替传统科学计算的超大规模偏微分方程的时序求解,从而可以实现快速完成全球未来1小时到7天的天气预报,预测精度比欧洲中期天气预报中心高20%以上。在这两张台风轨迹图中,蓝色轨迹是欧洲中期天气预报中心给出的预测,实际路径是黑色轨迹,华为盘古大模型的预测的路径是红色轨迹,可以看出,这个预测非常接近实际情况。

再比如制药领域,药物靶点发现是药物研发过程的关键问题。传统的分子对接计算方法效率高,但是没有考虑蛋白质的柔性,导致搜索空间小,寻找到的靶点少;而分子动力学模拟考虑了蛋白质的柔性,但是计算量非常大。我们的专家与北大教授一起提出了基于元动力学的靶点发现和构象搜索算法,加速小分子遍历蛋白质的过程,对同样的构象搜索,传统方法需要37天,华为只需要6个小时,提升了150倍效率。

在软件编程上,除了用传统AI在大量已有代码中进行检索和推荐外,我们也在发展科学的模型驱动和形式化方法。也通过新的AI计算模式,来研究定理自动证明问题。比如拓扑斯理论有助于探索范畴证明、同余推理系统、自动理论导出,提升定理证明器的水平,希望解决形式验证中的状态爆炸问题和自动模型抽象问题,增强形式验证能力。

在走向智能社会的过程中,可能有超过百倍、甚至千倍的信息需求增长。我们将这些面向未来的思考放在黄大年茶思屋网站上,促进开放的探讨交流,希望能与伙伴们一起,开展相关的基础科学研究与技术创新,重构基础理论、重构架构、重构软件。同时我们也赞助青年学者,并在ICPC、IMC、以及其他全球学生奥林匹克竞赛中,分享这些挑战和方向、赞助学生训练营、激励和培养更多的未来领军人才。

免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。