如今AI正在交通、教育、医疗、安防等各个垂直领域扮演重要角色。而AI要想占据更为广阔的舞台,就必须继续在应用、场景等层面继续深入。

目前,国内的AI企业正积极布局,充分发挥各自的优化,携手共建全新AI产业形态。从这点看,瑞芯微与百度展开的深度合作,其实就是在为AI生态建设出一份力。

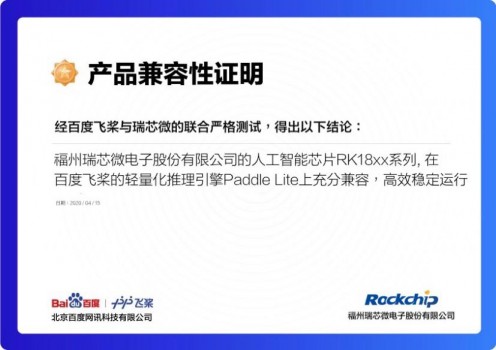

5月13日,瑞芯微Rockchip正式宣布,旗下AI芯片RK1808、RK1806适配百度飞桨(PaddlePaddle)开源深度学习平台,充分兼容飞桨轻量化推理引擎Paddle Lite。基于此次合作,双方有望为AI行业赋能更多应用、场景,加快AI产品的落地速度。

百度飞桨与瑞芯微兼容性认证书

瑞芯微和百度的合作是从硬软两方面赋能AI应用,在当下的AI时代,深度学习框架和操作系统类似,起着承上启下的作用,连接芯片与应用。而拥有强大算力的AI芯片加持后,AI技术将得到更广泛普及。

其中,百度飞桨集深度学习核心训练和预测框架、基础模型库、端到端开发套件、工具组件和服务平台于一体。Paddle Lite是飞桨推出的一套功能完善、易用性强且性能卓越的轻量化推理引擎,支持多种硬件、多种平台。

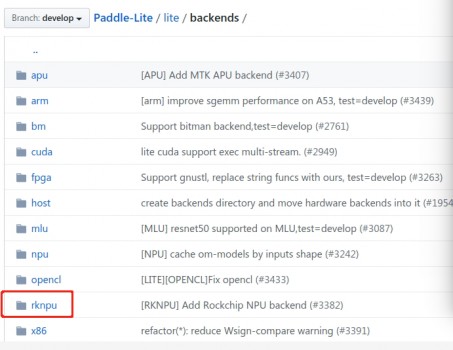

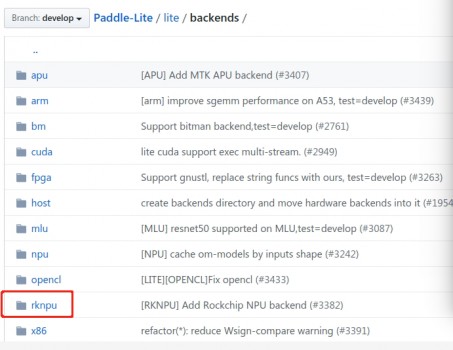

瑞芯微RK18xx系列芯片适配Paddle Lite

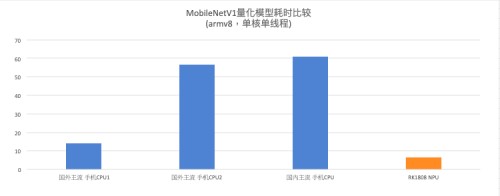

瑞芯微的AI芯片RK1808及RK1806,则内置独立NPU神经计算单元,INT8 算力高达3.0TOPs。它们采用22nm FD-SOI工艺,相同性能下的功耗相比主流28nm工艺产品降低约30%。经实测,瑞芯微AI芯片在Paddle Lite中运行MobileNet V1耗时仅为6.5 ms,帧率高达153.8 FPS,二者充分兼容并高效稳定运行。

从实测结果看,与手机等移动端常用的国内外主流CPU相比,RK18系列NPU在MobileNET_v1的耗时表现上佳。这也能够佐证,在AI相关的图像分类、目标检测、语音交互等领域,专用AI芯片将带来更出色的效果。

瑞芯微RK18xx系列芯片在MobileNETV1上对比主流CPU性能卓越

不难发现,通过适配飞桨开源深度学习平台,瑞芯微的AI芯片将更好地赋能国内用户的业务需求,为端侧AI提供强劲算力。二者在融合之后,事实上将软硬件的结合优势全面展现出来。由此,更多AI应用、场景等自然可加速落地。据悉,双方的合作不止于此,除RK1808及RK1808,瑞芯微旗下搭载NPU的AI系列芯片也将陆续升级适配百度飞桨。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )