6月30日,全球权威AI基准评测MLPerf™最新V2.0训练评测成绩榜单公布。浪潮AI服务器表现优异,继两月前在MLPerf™V2.0数据中心推理评测中斩获全部冠军后,本次又在MLPerf™V2.0单机训练性能继续保持领先。

本次MLPerf™评测吸引了包括谷歌、NVIDIA、浪潮信息、百度、Intel-Habana、Graphcore等全球21家厂商和研究机构参与,共有264项评测成绩提交,是上一轮基准评测的1.5倍。评测任务涵盖了当下主流AI场景,包括自然语言处理(BERT)、智能推荐(DLRM)、图像分类(ResNet)、医学影像分割(3D U-Net)、轻量级目标物体检测(RetinaNet)、重量级目标物体检测(Mask R-CNN)、语音识别(RNN-T)以及强化学习(Minigo)8类AI任务。

在单机训练评测的固定任务中,浪潮信息以高端AI服务器斩获自然语言理解(BERT)、智能推荐(DLRM)、语音识别(RNN-T)三项性能成绩第一,位列单机冠军榜首。在本次配置8颗NVIDIA A100 Tensor Core GPU的主流高端AI服务器中,浪潮AI服务器斩获5项任务最佳成绩(BERT、DLRM、RNN-T、ResNet、MaskR-CNN)。

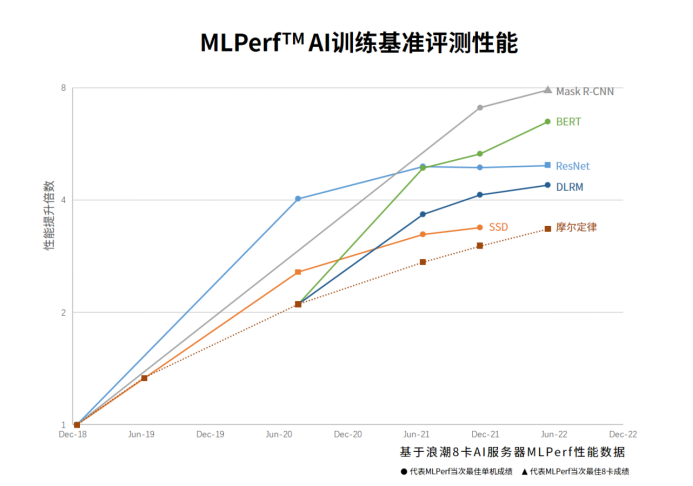

超越摩尔定律,持续领跑AI计算性能提升

MLPerfTM评测组织机构MLCommons 执行主任David Kanter 在此次成绩发布会上表示,自首次公布评测基准以来,MLPerf性能提升速度远超过摩尔定律。考虑到业界对计算和AI的需求正以惊人的速度增长,这让人非常振奋。

自参加MLPerf™AI性能评测以来,浪潮AI服务器通过软硬件全面优化,持续实现AI性能突破。相较于2018年12月MLPerf™ 初始版本V0.5的典型配置8卡机型的性能数据,浪潮AI服务器的性能显示出大幅提升,提升比例最高达789%,2.35倍于摩尔定律增速。

浪潮AI服务器在MLPerf™基准评测中的卓越表现,得益于浪潮信息在AI计算系统上优异的设计创新能力和全栈优化能力。浪潮AI服务器针对AI训练中常见的密集I/O传输瓶颈,通过PCIe retimer-free 设计实现了CPU-GPU间通道免中继高速互联,大幅降低通信延迟;并针对高负载多GPU协同任务调度,以及NUMA节点与GPU之间的数据传输性能进行了深度优化,确保训练任务中的数据I/O通路处于最高性能状态;在散热层面,率先实现4U空间内部署8颗500W的高端NVIDIA A100 TensorCoreGPU,并支持风冷、液冷两种散热方式。同时,在模型训练全流程中,浪潮AI服务器持续通过优化预训练数据处理、GPU之间高速通信、GPU核心加速等关键模块,最大化提升了AI模型的训练性能。

大幅提升Transformer训练性能

当前,基于Transformer神经网络的预训练大模型正引领新一代AI算法发展,并逐步从自然语言处理走向计算机视觉、多模态等领域。MLPerfTM评测任务中的BERT模型即是基于Transformer架构的模型。Transformer简洁、可堆叠的架构使得开发极大参数量、基于极大数据集的预训练大模型成为可能,这带来了模型算法能力的大幅提升,但同时也对AI计算系统的处理性能、通信互联、I/O性能、并行扩展、拓扑路径及散热能力提出了更高的要求。

在本次BERT评测任务中,浪潮AI服务器通过优化数据预处理、GPU之间密集参数通信、超参数自动寻优等,进一步提升了BERT训练性能,在15.869分钟内即在Wikipedia数据集的2850176条数据上完成了3.3亿参数的BERT模型训练,相较于V0.7版本的最佳成绩49.01分钟的性能提升达到309%。至此,浪潮AI服务器已经连续三次获得MLPerfTM训练BERT任务性能冠军。

浪潮信息在MLPerf™ V2.0训练评测中取得佳绩的2款AI服务器分别是NF5488A5及NF5688M6。NF5488A5是全球首批上市的NVIDIA A100 Tensor Core GPU服务器,在4U空间支持8颗由NVIDIA NVLink 互联的NVIDIA A100 Tensor Core GPU和2颗AMD Milan CPU,同时支持液冷和风冷散热技术,累计斩获40项 MLPerf™ 冠军。NF5688M6是面向大规模数据中心优化设计的具备极致扩展能力的AI服务器,支持8颗第三代 NVLink 互联的NVIDIA A100 Tensor Core GPU 和两颗Intel Ice Lake CPU,支持多达13张PCIe Gen4 的IO扩展能力,累计斩获25项 MLPerf™ 冠军。

附:MLPerf™简介

MLPerf™ 是影响力最广的国际AI性能基准评测,由图灵奖得主大卫•帕特森(David Patterson)联合顶尖学术机构发起成立。2020年,非盈利性机器学习开放组织MLCommons基于MLPerf™ 基准测试成立,其成员包括Google、Facebook、NVIDIA、英特尔、浪潮信息、哈佛大学、斯坦福大学、加州大学伯克利分校等50余家全球AI领军企业及顶尖学术机构,致力于推进机器学习和人工智能标准及衡量指标。目前,MLCommons每年组织2次MLPerf™ AI训练性能测试和2次MLPerf™AI推理性能测试,以便快速跟进迅速变化的计算需求和计算性能提升,为用户衡量设备性能提供权威有效的数据指导。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )