在AI大潮的推动下,基础设施市场正在复苏。戴尔科技近期发布了截止于2月3日的2024财年第四季度财报,第四财季营收为 93 亿美元,环比增长 10%。戴尔科技业绩回升主要得益于AI优化的服务器业务的增长,本季度AI服务器订单增长了40%,积压订单近乎翻倍达到29亿美元,而前一季度仅为16亿美元。

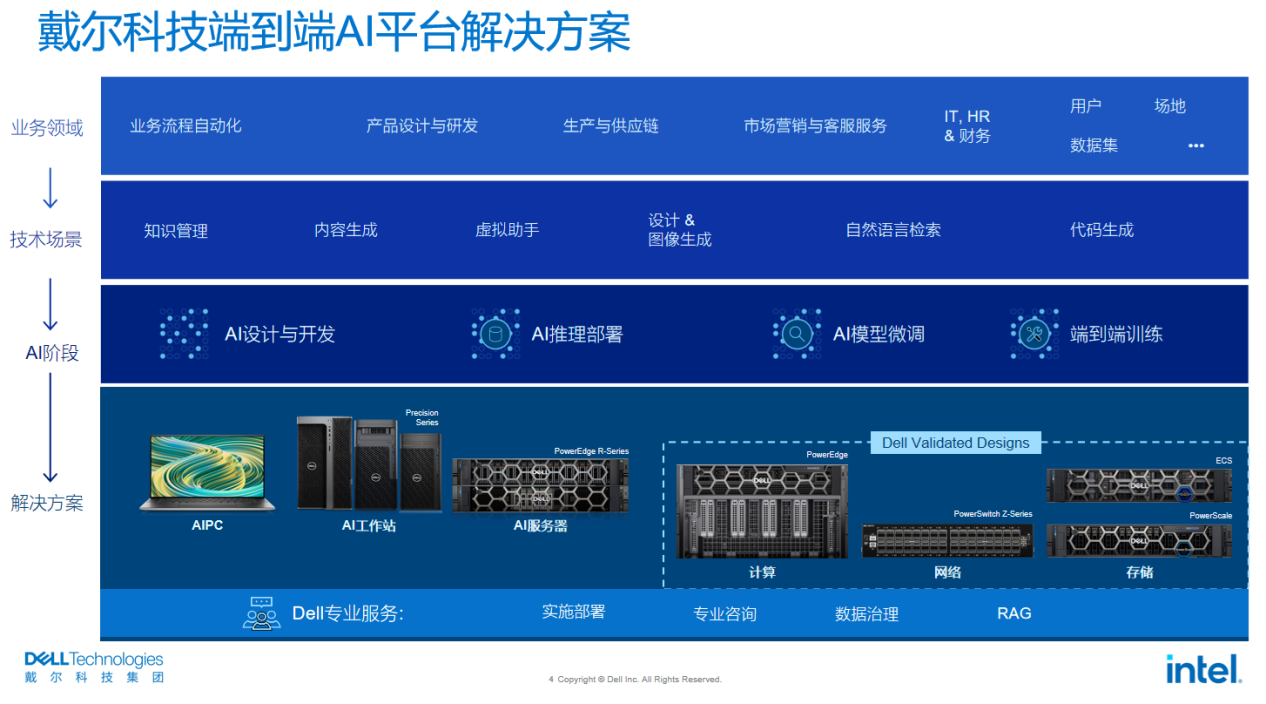

戴尔科技的AI服务器业务增长是整个基础设施市场最新变化的一个缩影。去年以来企业对人工智能应用的热情不断高涨,ChatGPT、Sora的先后爆火更是为人工智能热火上加油,带动了对AI基础设施的强劲需求。为了满足这些需求,戴尔科技推出了不少创新的产品和技术来帮助企业拥抱AI。

AI应用普及

推动基础设施升级

在过去的几年里,AI应用场景越来越丰富,智能化水平不断提升。一个明显的变化是,从过去集中在以图像识别、视频分析为主的感知智能逐渐扩展到以ChatGPT为代表的认知智能,文档检索、文档生成成为了新的主流应用场景,同时,以Sora为代表的多模态AI技术也开始方兴未艾。

蓬勃发展的AI应用背后离不开底层基础设施的支持。以大模型的训练和推理为例,大模型的参数量已经从数十亿增加到几百亿、几万亿甚至更高,更大的模型带来了更大的AI算力需求。有数据显示,AI所消耗的算力平均每3至4个月就会增长一倍,而这部分增长的算力需求大部分将由GPU承担,直接带动了异构计算的普及。

另一方面,计算规模越来越大,越来越多地通过集群来承载,万卡、十万卡GPU规模的数据中心也不鲜见。与计算规模扩大同时增加的还有网络通讯需求,让高带宽、低延迟网络交换设施成为AI系统的必要组成部分。

与此同时,新兴的AI应用对存储系统的要求也被提高了。功能更强、规模更大的算法模型需要搭配数量更多、质量更高、更加多元化的训练数据才可能达到预期效果,否则很容易因训练数据不足造成模型欠拟合,而这意味着存储系统性能更高、更稳定,同时成本更低。

市场的需求基础设施厂商都看到了,以戴尔科技为代表的很多基础设施厂商也推出了大量创新的产品和技术。

多元化AI计算平台

加速智能跃迁

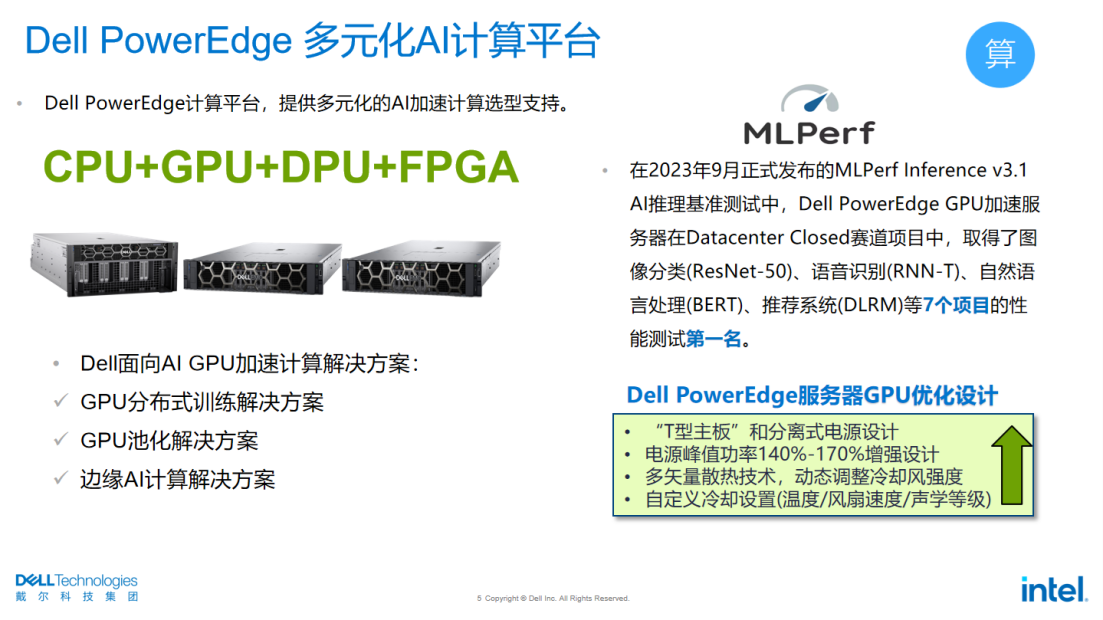

众所周知,传统数据中心的典型架构是以CPU为中心,而今天在大模型训练和推理需求的推动下,CPU+GPU为代表的异构计算正在成为主流,GPU成为越来越多服务器的标准配置。

顺应市场的最新需求,戴尔科技推出了多款PowerEdge服务器,它们专门针对GPU计算设计和优化,能支持英特尔等不同品牌的GPU加速卡,可满足不同应用场景的需求。

“围绕AI 应用的GPU加速,戴尔科技能提供像GPU池化、GPU分布式训练、GPU集群管理和资源调度、边缘AI计算等GPU加速计算解决方案。”戴尔科技集团信息基础架构解决方案事业部企业技术架构师、全球CTO大使吴跃表示。

他表示,PowerEdge 服务器设计中有很多针对GPU的专门设计。比如,多矢量散热技术的应用可以保证均匀冷却服务器各部件;电源增强设计(即瞬时功率)可以达到电源标称功率的1.4到1.7倍,以应对GPU开机过程中的启动风暴。这些设计都是为了确保GPU在服务器内达到最佳运行状态。

在AI的公开基准测试中戴尔PowerEdge表现优异。MLPerf是当前AI领域关注度和参与度最高的计算性能基准测试,在去年9月份发布的MLPerf Inference V3.1的推理基准测试中,共有26个厂商提交了超过13500条的测试记录。在20个数据中心项目赛道中戴尔科技取得了7个项目的第一名,另外4个项目的第二名。在所有参与评测的GPU服务器产品中取得最好的综合成绩。

除了多款GPU服务器外,戴尔推出的搭载英特尔Xeon Max处理器的PowerEdge服务器也值得一提。目前戴尔科技有三款服务器可以支持Xeon Max处理器,包括2U 两路的计算平台PowerEdge R760、1U 两路的计算平台PowerEdge R660以及2U 4节点PowerEdge C6620。

Xeon Max处理器是英特尔推出的业内首款集成HBM的x86 CPU,其中集成了64GB的HBM,内存带宽可达到1TB/s,无需GPU加速卡就可实现内存带宽密集型应用的加速,如模型推理与模型微调等。

相关测试表明,单个Xeon Max处理器即可完成60亿、130亿规模的大语言模型的加载和应用;对于对话式AI的场景,会话首个token生成延迟小于3秒钟,下一个token生成延迟小于100毫秒。而且,由于所有主流AI框架与加速库都支持x86计算,在CPU上运行AI模型可以减少代码改动量,大大简化了AI应用的开发和部署。

吴跃表示,为了持续引领AI基础设施技术创新,加速AI应用的落地,戴尔科技还成立了AI HPC创新实验室,专门从事AI计算、并行计算的前沿技术研究、效能的基准测试等相关工作。超级计算机Ratter就是戴尔AI&HPC创新实验室打造的GPU超算集群。戴尔很多AI以及使用GPU加速的HPC解决方案(如CAE、分子动力学、生命科学等)也是在Ratter集群上首先进行测试和优化的。

从边到端

让AI算力无处不在

实际上,基础设施相关的技术创新不只是发生在计算领域,也发生在存储和网络领域,同时,也不只是在云端和数据中心,还发生在端侧,并正在酝酿一场从云到端、全面的升级。

比如,为了减少数据传输的延迟,戴尔PowerScale今年新增了Multipath Client driver(多通道客户端驱动程序),借此单个客户端就可以能实现40GB/s的峰值带宽,可为高密度的GPU算力服务器提供充沛的后端存储性能。

OneFS是戴尔科技自研的文件系统,全闪PowerScale搭配OneFS 9.7文件系统,存储的流式读性能是上一代平台的两倍,流式的写性能是上一代平台的2.2倍,可以有效提高GPU在模型预训练和微调阶段的工作效率。

当然,在端侧的创新同样不少。从去年9月份英特尔推出AI PC概念以来,AI PC迅速被市场接受。IDC的预测,今年新增PC中一半以上将是AI PC;2027 年将进一步提升至 84.6%。戴尔科技也全面拥抱AI PC,今年新发布的AI工作站Precision 7960单台将支持4块双宽的GPU,最高配置4TB的内存和152TB的本地存储,为AI落地工作站提供强力支持。

谈到AI在边缘端的落地,英特尔不可不提。除了发力AI PC之外,英特尔还在其他方面持续优化CPU面向AI应用的性能,也为戴尔科技丰富自己的产品线提供更多选择。比如,英特尔从第四代至强可扩展处理器开始新增AMX加速器,无需GPU就可显著提升AI推理和训练的性能。根据英特尔的资料,AMX对于INT8精度有8倍的性能提升,对BF16精度有16倍的性能提升。而且由于AMX内置于CPU中,因而无需专门构建解决方案。

另一方面,英特尔也联手合作伙伴推出面向边缘的AI解决方案参考设计。英特尔Edge AI Box 就是其中之一,AI-BOX在搭载英特尔酷睿处理器的单一计算盒内集成了视频解码和分析功能,既可作为连接到 IP 摄像头或网络录像机 (NVR) 等视频源的独立设备,实时进行边缘视频分析,也可以连接到网络并充当网络上的独立 AI 服务,按需运行离线深度学习分析,部署非常方便。

英特尔中国解决方案部AI架构师俞巍表示:“围绕边缘AI的落地和部署,英特尔联合戴尔科技等合作伙伴共同打造了很多基于英特尔软硬件栈的边缘AI解决方案,以支持无处不在的AI应用。”

实际上,除了英特尔外,戴尔科技还与很多厂商有合作,其中与ISV合作研发面向细分领域的解决方案就是一种重要的合作方式。

当下,向量数据库+大模型的RAG(检索增强生成)非常热门。因为RAG既可以发挥大模型的语言生成能力,又可以借助向量数据库解决大模型的幻觉问题,被认为是一种非常有应用前景的AI落地形式。达观数据是一家专注于智能文本处理技术的国家级专精特新“小巨人”企业,其智能知识管理系统在行业内拥有不少用户,现在戴尔科技就在和达观数据合作,共同探索RAG技术与智能知识管理的融合解决方案。

另外,戴尔科技推出的经过验证的各种参考设计 (AI Validated Design Solution) 以及配套的技术白皮书和效能的验证,其中就离不开各种合作伙伴的支持。

“随着AI技术的迭代,AI场景与AI模型规模越发复杂,对AI算力与AI训练数据的需求也会更加地旺盛,AI基础设施未来几年将会持续成为全球IT投资的热点之一。”吴跃表示,作为领先的基础设施供应商,戴尔科技会和合作伙伴一起积极拥抱AI,通过技术创新推动基础设施的升级,加速AI应用的普及。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )