极客网·人工智能5月17日 我们正处在一个越来越容易制造虚假信息的时代。深度造假(Deepfakes)、扩散模型、生成对抗网络(GAN)以及其他AI技术被居心不良者用于伪造照片和视频,或者创建从未发生过的事件的一些照片或视频。

虽然AI生成的图像和信息有许多积极的应用,但它们也可能被用于邪恶的目的。而有了无缝操纵和扭曲现实的能力,居心不良者可以利用AI欺骗公众,传播错误信息。

以下简要探讨深度造假的威胁,并介绍一些检测AI生成信息的技巧。生成式AI这个领域正在迅速发展,所以必须寻找到新的技术和对策。

AI可以生成哪些信息?

虽然罗马教皇穿着羽绒服、美国前总统唐纳德·特朗普拒捕及乌克兰总统泽连斯基呼吁投降等这些事件并没有真实发生,但有关他们的图片和视频已经在社交媒体上流传。

这些就是用AI系统创建的图像和视频。如今,有几种深度学习技术可以制造虚假信息:

· Deepfakes:Deepfakes使用两个深度神经网络来学习演员和目标人物的面部特征。然后将目标的面部映射到演员的脸上。有了这样的算法,Deepfakes已经变得更加真实以及非常有说服力。

· 扩散模型:这些是在大量图像和字幕数据集上训练的神经网络。通过找到连接文本和图像的模型,这些模型可以从文本描述中生成令人信服的图像。DALL-E2、Midtravel和Stable Diffusion是流行的扩散模型的三个例子。

· 生成对抗网络(GAN):生成对抗网络(GAN)是一种深度学习系统,可以从零开始创建逼真的图像,例如人脸和风景。

AI生成信息的潜在危害

由Midjourney生成的美国前总统唐纳德·特朗普拒捕的虚假图像

Deepfakes已经推出几年的时间,但在过去几年里,这种技术取得了令人印象深刻的进展。通过与其他生成式AI技术(如语音合成器和大型语言模型)相结合,其生成的内容可能成为真正的威胁。

虽然我们仍处于可以分辨AI生成的信息的阶段,但需要注意它们会如何影响公众舆论:

· 错误信息的传播:图片和视频在社交媒体上传播得非常快。当事实核查人员或AI生成信息的目标做出回应时,可能已经造成了损害。特别是当Deepfakes的创造者可以将它们与逼真的AI生成的声音结合起来时,它们会变得非常有说服力。

· 曼德拉效应:很多人都记得上世纪80年代纳尔逊·曼德拉在南非监狱里去世的传闻。实际上,他于1990年从监狱获释,后来成为南非总统。但是,即使事实是显而易见的,虚假的故事已经在许多人的脑海中根深蒂固。这就是众所周知的“曼德拉效应”,还有许多其他的真实例子。而有了Deepfakes,这样的问题可能会更频繁地出现。

· 社会工程:Deepfakes和生成式AI使制作令人信服的电子邮件、视频、网站等以及进行网络钓鱼变得更加容易。居心不良者可以使用这些AI模型来创建逼真的化身,制作专业电子邮件,并创建听起来像真人的语音信息。他们可以利用这些数据欺骗受害者泄露隐私信息,向网络攻击者汇款,或者实施其他有害的活动。例如,去年一家假冒的律师事务所使用生成式AI通过DMCA通知勒索受害者。

· 信任流失:Deepfakes的兴起将使人们更难信任他们所看到的任何东西,判断真假将变得越来越困难。一方面,居心不良者会试图用生成式AI扭曲真相;而在另一方面,他们可能会否认真实的证据,并声称真实的文件和视频是由AI生成的。

如何分辨出那些AI生成的信息?

虽然研究人员不断创造新的技术和工具来检测Deepfakes和其他AI系统生成的图像和视频。但这是一场猫捉老鼠的游戏,因为随着技术的进步,原有的检测技术就会过时。目前有一些关键的方法可以帮助检测深度造假视频、GAN人脸和扩散模型生成的图像:

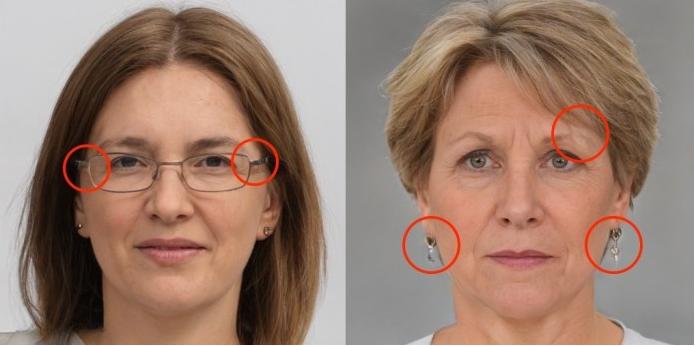

生成对抗网络(GAN)表面具有清晰可见的伪影

· 面部失真:Deepfakes和生成对抗网络(GAN)生成的人脸通常在面部整体上的光照不一致,还可以在细节和边缘所在的位置找到失真的痕迹,例如发际线、眉毛、面部毛发、耳环,尤其是眼镜的边框。

· 眼睛和嘴唇的动作:在Deepfakes视频中,需要特别注意面部的运动部分。其阴影是否一致? 眨眼看起来真实吗?在人物说话时,嘴巴和牙齿看起来自然吗?

· 照明和反射:生成式模型试图预测场景中的照明。当然,并不是所有的预测都是正确的,所以如果仔细观察,就会发现阴影和反射偶尔会出现故障。这些都是AI生成图像的迹象。

· 比例:扩散模型生成的图像通常有错误的比例,例如手臂、脚、前臂等部位的长度错误。乍一看,这些错误可能并不明显,但通过仔细观察,很快就会发现是AI生成的图像。

· 详细对象:当前的生成模型在合成性和详细对象方面尤其糟糕。例如手部、建筑以及多个组成部分构成的物体。这些图像的背景通常会包含一些明显的错误。

· 来源:当然,检测Deepfakes和AI生成的图像的重要方法之一是验证它们的来源。在谷歌或必应上进行反向图片搜索,查看这张照片是否在社交媒体以外的地方出现过。查看是否有信誉良好的媒体报道了这些事件。如果是与朋友或家人有关的比较私密的图像,在相信这一事实之前需要和他们核实。

人们需要面对生成式AI快速发展的这一现实,而开发人员则需要更加勤奋努力,并为应对其带来的挑战做好准备。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )