极客网·芯片7月16日 近日,ETNews 报道称,下一代低功耗内存模块 “SOCAMM” 市场已全面开启,英伟达计划在今年为其 AI 产品部署 60 至 80 万个 SOCAMM 内存模块。该产品甚至被业内称为 “第二代 HBM”,随着其在 AI 服务器和 PC 中的应用逐步增长,其大规模出货预计将对内存和 PCB 电路板市场产生积极影响。

知情人士透露,“英伟达正在与内存和电路板行业分享 SOCAMM 的部署量(60 至 80 万片),该模块将应用于其 AI 产品。”这是一种专注于低功耗的 DRAM 内存模块,也是英伟达正在推广的自有标准产品,它通过捆绑 LPDDR DRAM 来加强 AI 运算。与现有的笔记本电脑 DRAM 模块(LPCAMM)相比,其 I/O 速度提升,数据传输速度加快,并且结构紧凑,更易于更换和扩展。

横向来看,与美光此前生产的服务器 DDR 模块 “RDIMM” 相比,SOCAMM 的尺寸和功耗减少了三分之一,带宽却增加了 2.5 倍。英伟达计划将 SOCAMM 率先应用于其 AI 服务器产品和 AI PC(工作站)产品。首批搭载 SOCAMM 内存的产品是最新的 GB300 Blackwell 平台,这一举动暗示了英伟达打算为其众多 AI 产品转向新型内存的意图。值得一提的是,英伟达在今年 5 月 “GTC 2025” 上发布的个人 AI 超级计算机 “DGX Spark” 也采用了 SOCAMM 模块,因此其需求预计还会扩展到 PC 市场。

尽管最高 80 万的目标部署量远低于其内存合作伙伴今年的 HBM 出货量(预估 900 万),但预计其规模明年将开始扩大,尤其是在 SOCAMM 2 内存上市之后。目前美光是英伟达 SOCAMM 模块的唯一制造商,而三星和 SK 海力士据称也正在与英伟达接洽,希望为其生产 SOCAMM 模块。

在今年 3 月,美光、SK 海力士两大 DRAM 内存原厂就正式公布了新的 SOCAMM 内存模组。美光称该型内存条将被用于英伟达 GB300 Grace Blackwell Ultra 超级芯片,预计作为 Grace CPU 的可更换内存使用。SOCAMM 全称 Small Outline Compression Attached Memory Module,意即外形更为小巧的 CAMM 压缩附加内存模组,目前基于 LPDDR5X DRAM 颗粒。

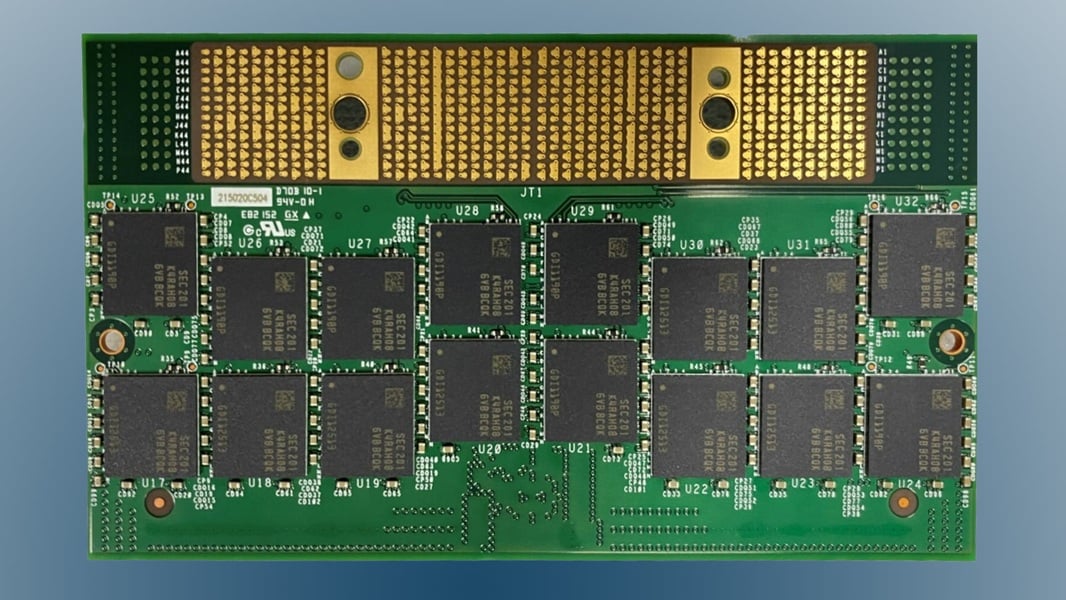

和此前的 LPCAMM2 类似,SOCAMM 目前同样也是单面四颗粒焊盘、三固定螺丝孔的设计。不过与 LPCAMM2 存在差异的是,SOCAMM 的顶部无凸出的梯形结构,这降低了整体高度,更适合服务器的安装环境和液体冷却。其外形尺寸为 90mm×14mm,采用 128bit 位宽;美光展示的产品基于 4 颗 16 芯堆叠的 16Gb DRAM,整体容量达到 128GB,支持 8533 MT/s,大小仅有行业标准 DDR5 RDIMM 的约 1/3,而凭借高速的 LPDDR5X 和更大位宽,SOCAMM 相同容量带宽可达 2.5 倍、功耗仅有传统方案的 1/3 。

随着 AI 技术的飞速发展,对内存性能的要求也越来越高。HBM 在当前的 AI 领域应用广泛,但 SOCAMM 的出现,为 AI 产品提供了一种新的内存选择方向。它不仅在带宽、功耗和尺寸上具有优势,其可扩展性和可维护性也为数据中心提供了高度优化的内存解决方案。英伟达大规模部署 SOCAMM 内存模块,无疑将对 AI 产品的性能提升带来积极影响,后续其在实际应用中的表现,以及对整个 AI 内存市场格局的改变,值得持续关注。

免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。